大模型技术因其良好的通用性与泛化性,显著降低了人工智能应用的门槛,其溢出效应正在加速推进新一轮的科技革命和社会产业的变革。尤其是以ChatGPT为代表的生成式人工智能应用的出现,使大模型的发展成为AI领域最重要的热点趋势,越来越多的科技巨头竞相推出千亿、万亿参数的大模型。而训练超大参数规模的大模型也给智能计算基础设施带来了前所未有的挑战。大模型的训练过程需要数千张GPU卡协同计算数周或数月,这就要求智能计算网络能够提供更强大的性能和更高的稳定性与可靠性。

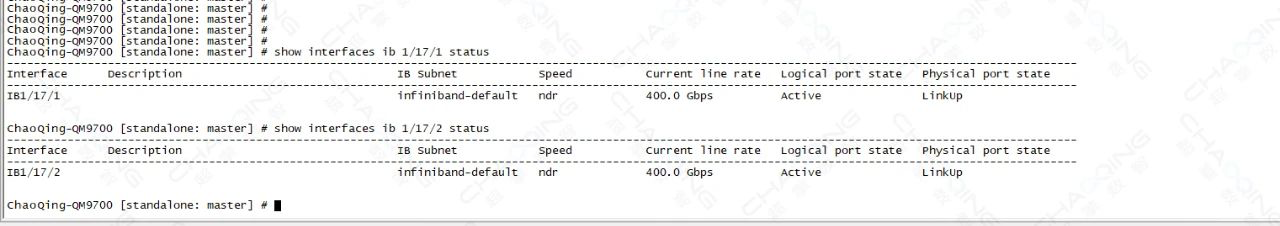

超擎数智凭借对高速率网络发展趋势的理解,和丰富的高性能网络项目实施经验,基于NVIDIA Quantum-2 InfiniBand平台为客户提供NDR (Next Data Rate)网络产品应用与连接方案。NVIDIA Quantum-2 InfiniBand平台以超高的带宽、超低的传输延时以及极简的运维成为了人工智能和超大规模数据中心的首选。与上一代产品相比,Quantum-2实现了两倍的端口速度,三倍的交换机端口密度,五倍的交换机系统容量,以及32倍的交换机AI加速能力。如果采用Dragonfly+拓扑,基于Quantum-2的网络可在3个hop内实现百万余个节点的400Gb/s连接能力。可为AI开发者和科研人员提供超强网络性能,帮助他们应对全球极具挑战的问题。

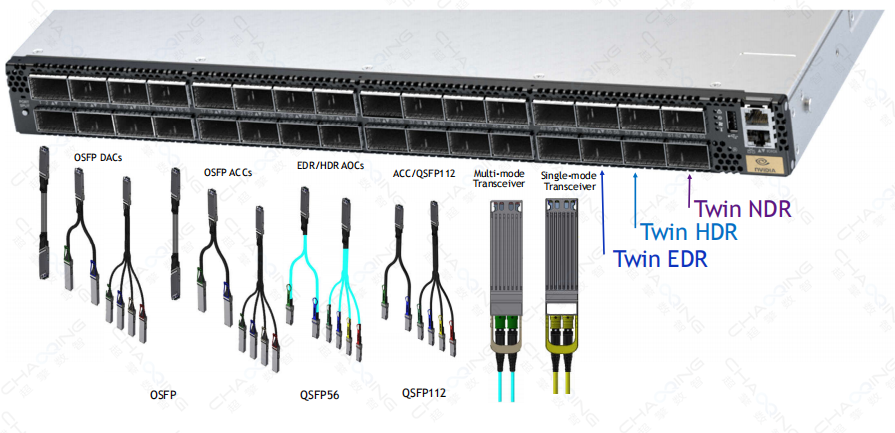

Quantum-2 InfiniBand交换机

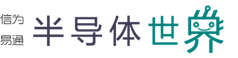

超擎数智提供基于NVIDIA Quantum-2的QM9700和QM9790交换机。NVIDIA Quantum-2盒式交换机主要有两个型号:QM9790和QM9700,两者主要区别在于管理方式,QM9700带管理接口,支持外部管理,而QM9790不支持,在端口形态、速率上则没有任何区别。QM9700系列交换机支持64个400G端口、或128个200G端口的灵活搭配,需要注意的是QM9700采用的1U的设计,单面板32*OSFP端口,每个OSFP端口支持2X400G速率,在交换机内部则以IB1/**/1、IB1/**/2的形式展示64个400G端口的信息。

NVIDIA Quantum-2搭载第三代NVIDIA SHARP技术,能够为各种规模的网络数据聚合创造几乎无限的可扩展性,其AI加速能力将达至前一代的32倍。此外,第三代SHARP技术可在不降低性能的情况下,支持多个租户或多个并行应用共享基础设施。MPI_Alltoall加速和MPI标签匹配硬件引擎以及其他功能(如高级拥塞控制、动态路由以及自我修复网络)可为高性能计算(HPC)和AI集群提供至关重要的增强功能,从而使其性能更上一层楼。

ConnectX-7 HCA网卡

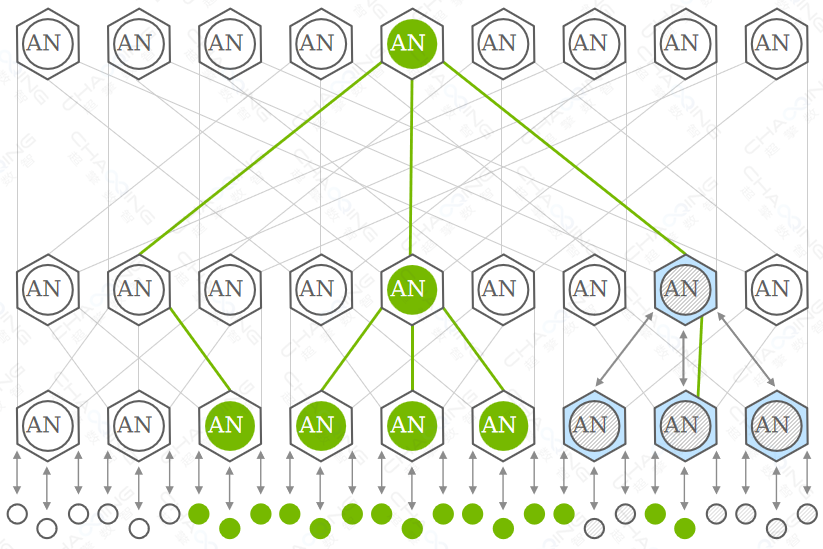

NVIDIA ConnectX@-7 InfiniBand网卡(HCA) ASIC可提供400Gb/s的数据吞吐量,并支持16通道的PCle5.0或PCle4.0主机接口。400Gb/s lnfiniBand采用先进的每通道100Gb/s的SerDes,通过交换机和HCA端口上的OSFP连接器实现物理连接。每个交换机OSFP连接器支持两个400Gb/s InfiniBand端口或200Gb/s InfiniBand端口。网卡HCA的OSFP连接器支持一个400Gb/s InfiniBand端口。400Gb/s线缆产品包括有源及无源铜缆、收发器以及MPO光缆。需要注意的是,虽然网卡与交换机都采用的OSFP封装,但在物理尺寸上有所区别:交换机端的OSFP模块带散热鳍片,而网卡端采用OSFP-RHS结构不带散热片,依靠网卡端口上的散热片辅助模块进行散热。

NDR光连接解决方案

超擎数智提供灵活的NDR光连接解决方案,NDR交换机端口的物理形态是OSFP,每个接口有八个通道,每通道采用100Gb/s的SerDes;所以从连接速率上来看,有800G to 800G、800G to 2X400G与800G to 4X200G三种主流连接方案;同时,每个通道支持从100Gb/s降至50Gb/s,所以它也可以与上一代HDR(HDR采用50Gb/s的SerDes)设备互连,即可以支持400G to 2X200G。

NDR系列电缆和收发器提供了丰富的产品选择,用于配置任何网络交换和适配器系统,专注于长达 2 公里的数据中心长度,用于加速人工智能计算系统。为了最大限度地减少数据重传,电缆和收发器都具有低延迟、高带宽人工智能和加速计算应用所需的极低误码率 (BER)。

从连接件类型上来看,主要有三种方式:无源铜缆DAC、有源铜缆ACC与光模块+跳线的方案。其中DAC支持1-3米的传输距离(其中直连DAC传输距离为2米),ACC支持3-5米的传输距离,多模光模块最远支持50米传输距离,单模光模块最远支持500米传输距离。

超擎数智NDR交换机到NDR设备连接方案

NDR InfiniBand Quantum-2交换机 —— NDR InfiniBand Quantum-2交换机

1、NDR光模块

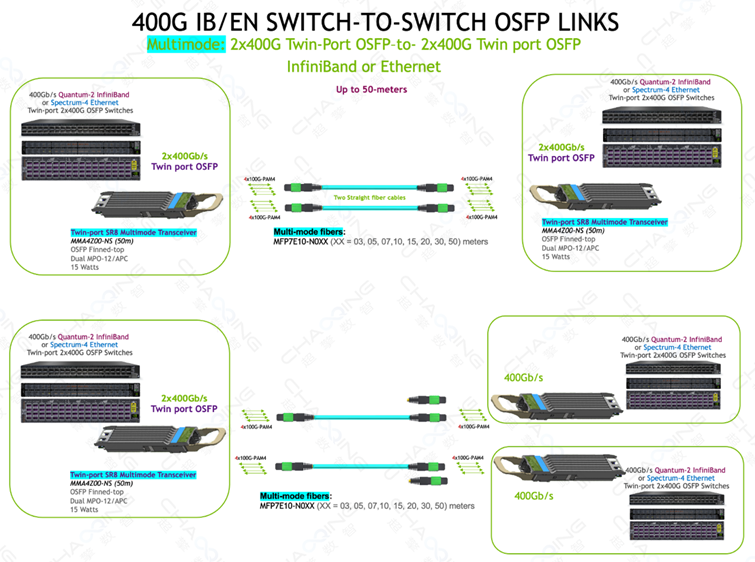

多模光模块——MMA4Z00-NS(50m)

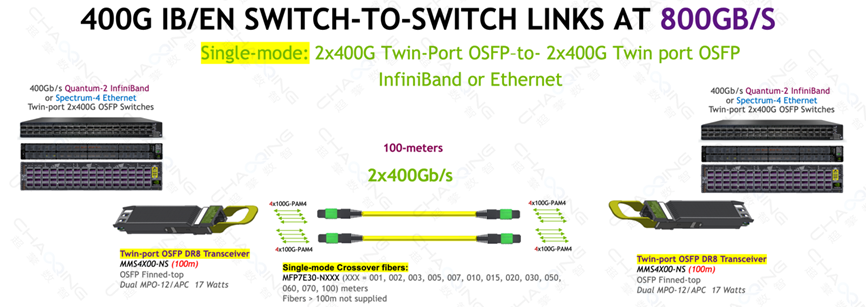

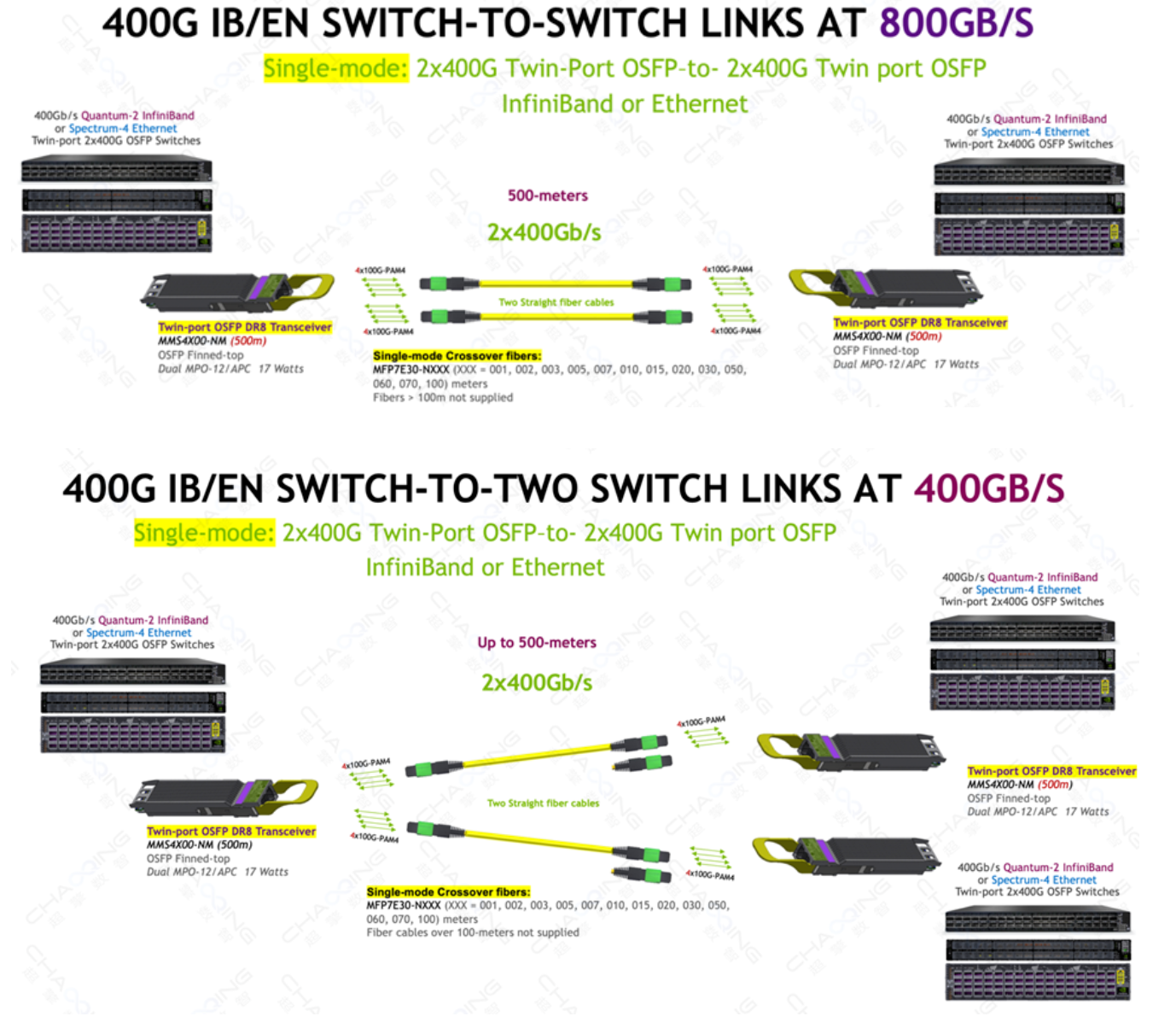

单模光模块——MMS4X00-NS(100m)、MS4X00-NM(500m)

① Single 2x400Gb/s OSFP - Single 2x400Gb/s OSFP:使用OSFP双端口收发器和两根直连MPO-12/APC光纤跳线以 800G (2x400G) 速率将两台OSFP端口的 QM9700/QM9790交换机连接在一起,多模最远传输距离可以达到50m,单模传输距离可以达到100m或500m;

② Single 2x400Gb/s OSFP - Dual 2x400Gb/s OSFP:使用OSFP双端口收发器和两根MPO-12/APC光纤跳线还可以路由到两个不同的交换机,形成两条 400Gb/s 链路,然后将额外的OSFP端口路由到更多的交换机。

800G SR8连接示意图

800G DR8 100m连接示意图

800G DR8 500m连接示意图

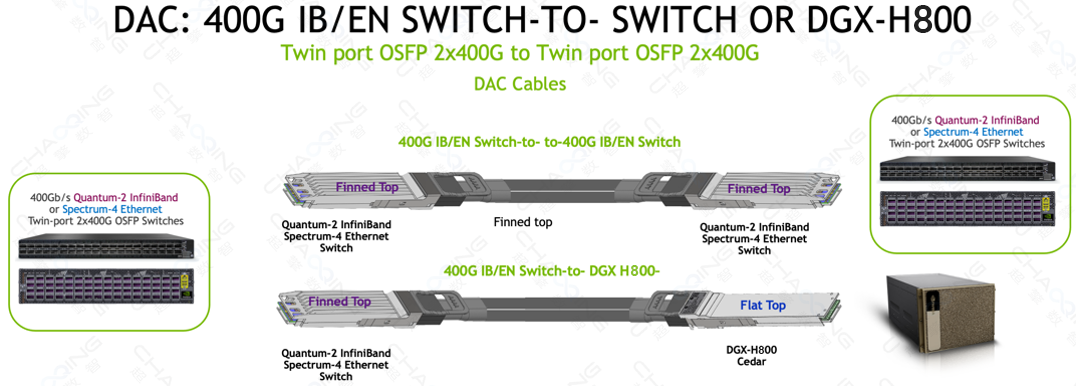

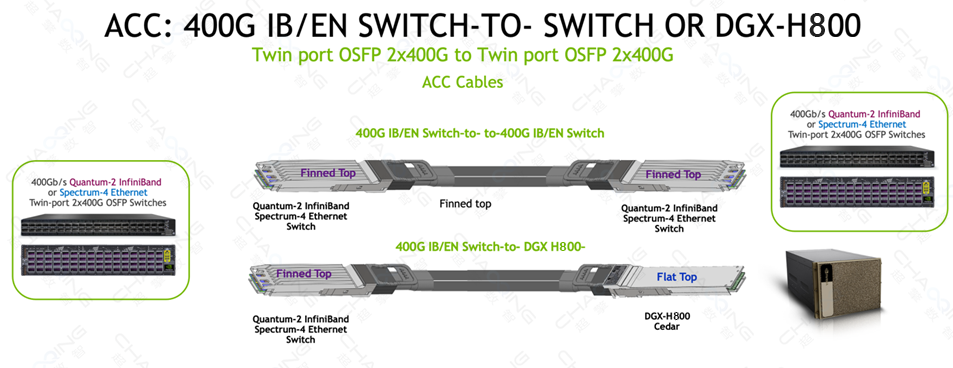

2、NDR Copper(DAC / ACC)

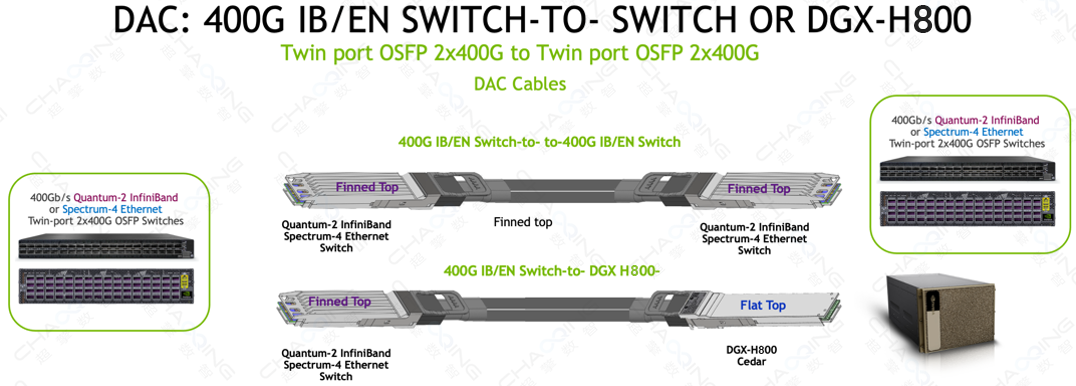

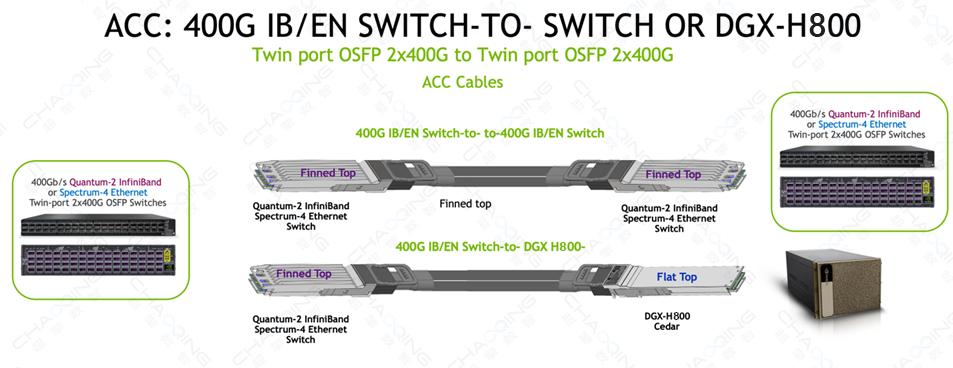

NDR Copper Cable的主要用途是将两个双端口、基于 OSFP 的 Quantum-2 InfiniBand 或 Spectrum-4 以太网交换机相互连接在一起,分为无源铜缆DAC和有源铜缆ACC,其中平顶Flat Top用于 DGX H800,翅片顶部Finned Top连接器用于 InfiniBand 或以太网交换机。

-MCP4Y10:无源铜缆(DAC),长度最长2m。

-MCA4J80:有源铜缆 (ACC),可将长度延长至 3、4 和 5 米,同时保持每端 1.5 瓦的极低延迟和极低功耗。

800G DAC连接示意图

800G ACC连接示意图

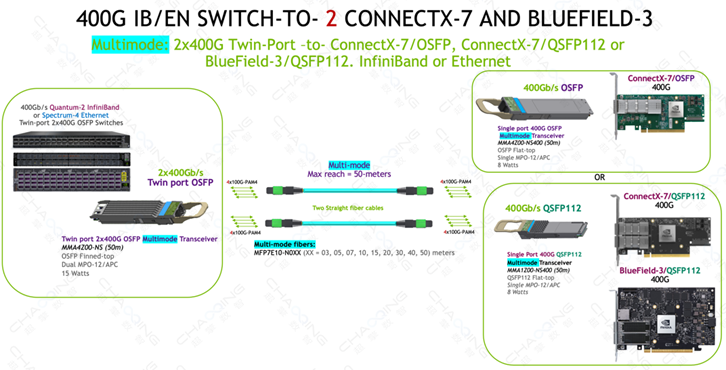

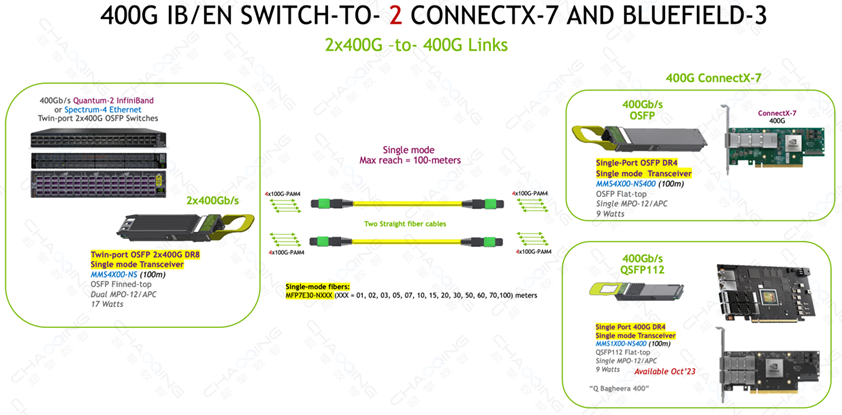

NDR InfiniBand Quantum-2交换机 —— 2 x 400G ConnectX-7(OSFP/QSFP112)Adapter/BlueField-3 DPU(QSFP112)

1、NDR光模块

交换机侧:800G Twin-port OSFP光模块——MMA4Z00-NS(50m)、MMS4X00-NS(100m)

网卡侧:400G Single port OSFP/QSFP112光模块——MMA4Z00-NS400 / MMA1Z00-NS400(50m)、MMS4X00-NS400(100m)

使用两根光纤跳线的双端口 OSFP 光模块最多可支持两个适配器和/或 DPU 组合。两条 4 通道光纤跳线中的每一条都可以连接到 OSFP 或 QSFP112 封装的 400G 光模块,多模最远传输距离可达 50 米,单模最远传输距离可达100m。

-仅 ConnectX-7/OSFP 支持单端口 OSFP。

-QSFP112封装光模块可用于ConnectX-7/QSFP112和BlueField-3/QSFP112 DPU。

-使用 OSFP 或 QSFP112 的 ConnectX-7 和 BlueField-3 的任意组合可同时与双端口 OSFP 光模块连接使用。

800G SR8 —— 2x400G SR4连接示意图

800G DR8 —— 2x400G DR4连接示意图

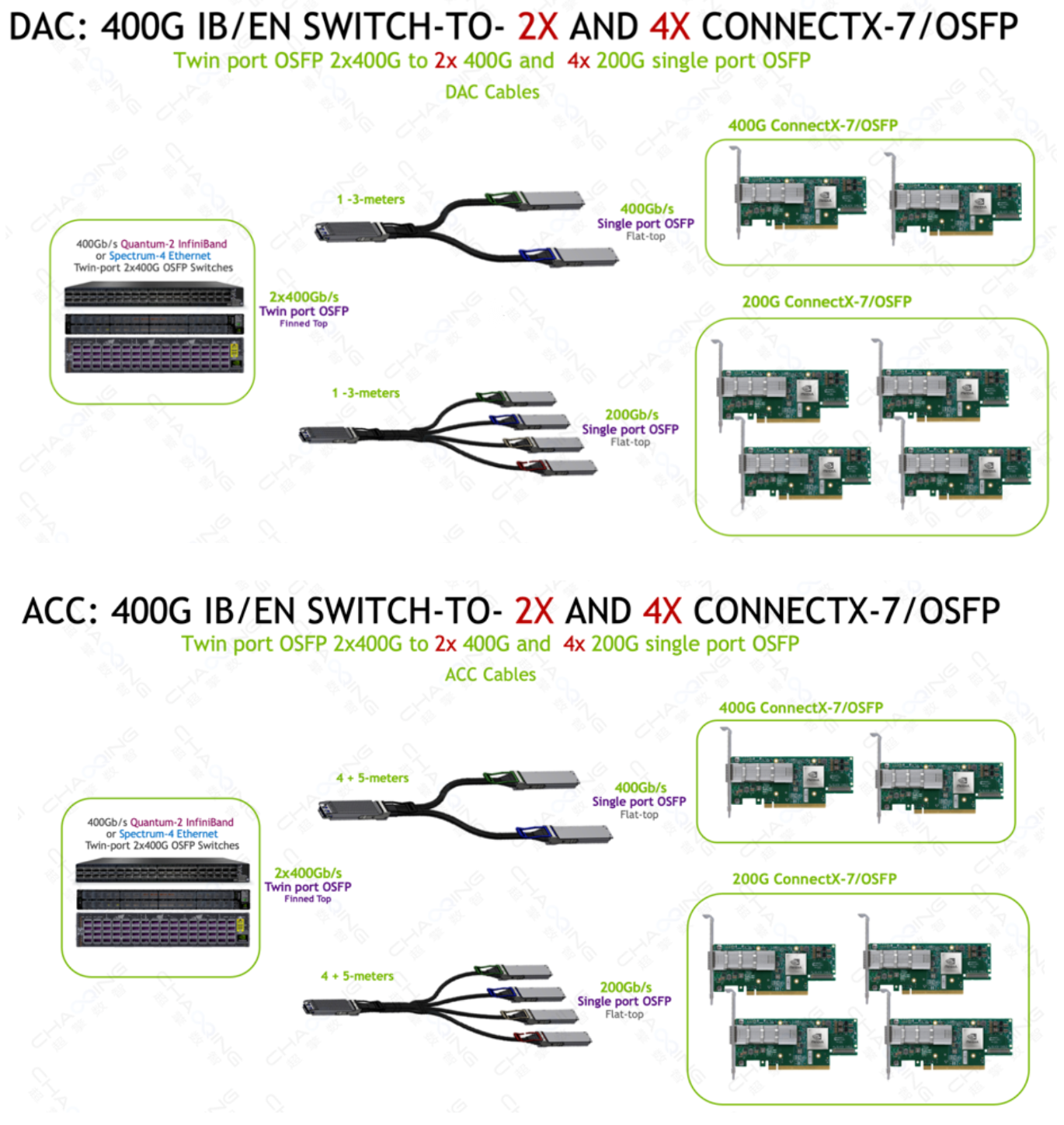

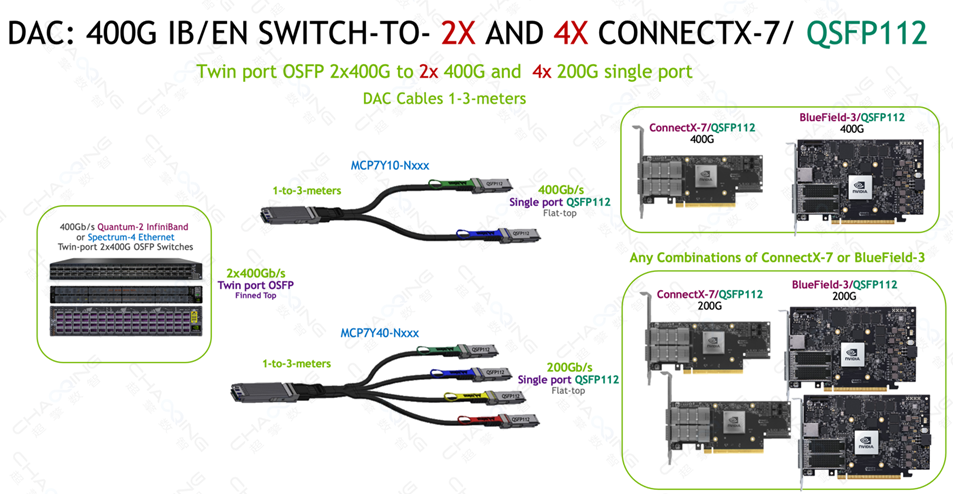

2、NDR Copper(DAC /ACC)

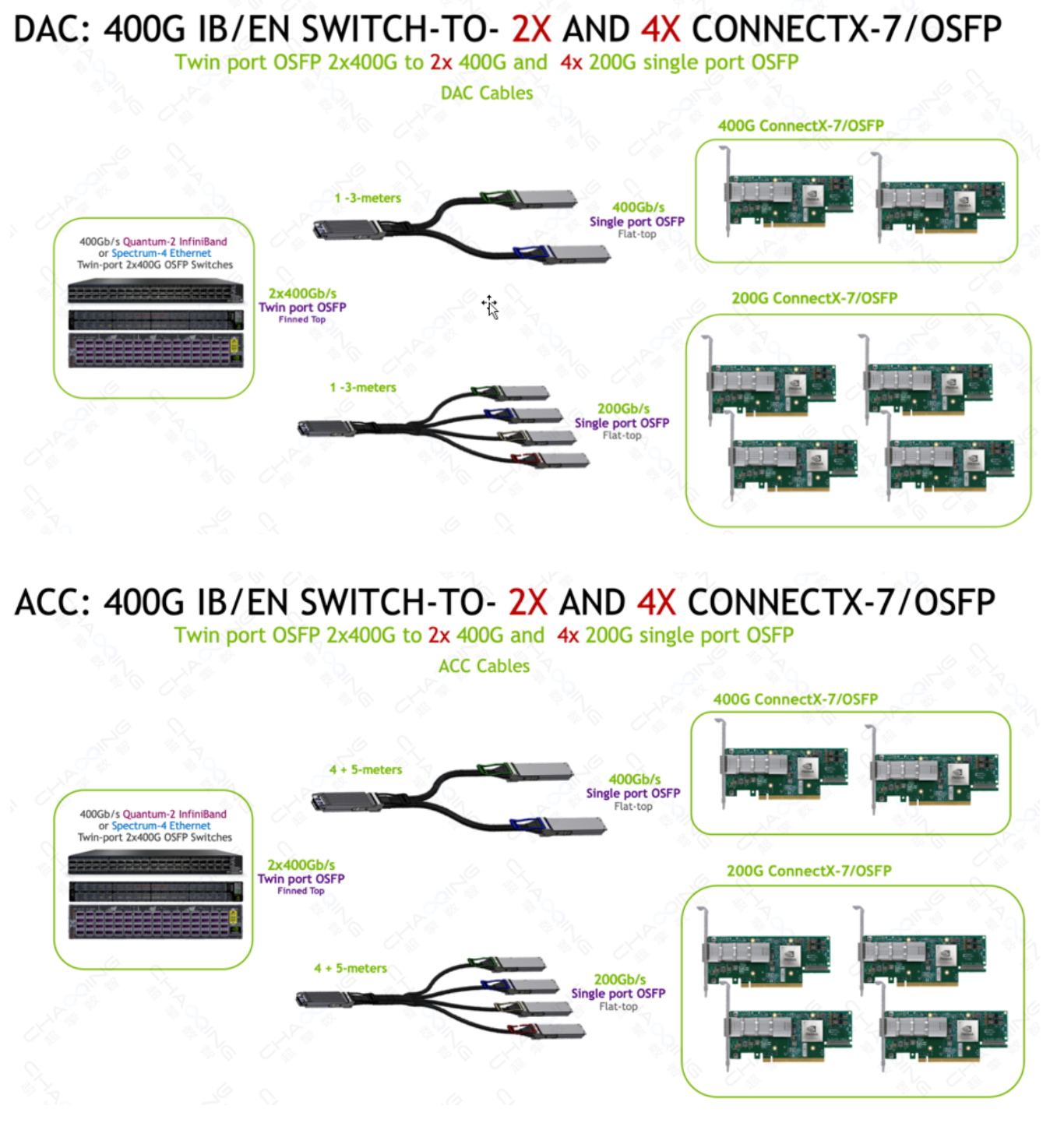

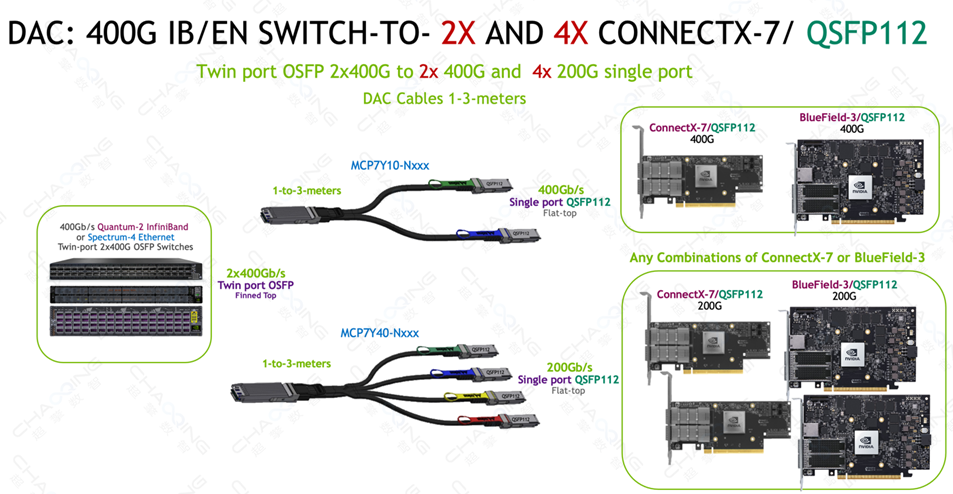

800Gb/s 双端口 OSFP至 2x400Gb/s OSFP/QSFP112 分支铜缆适用于 400Gb/s NVIDIA 端到端 Infiniband和以太网解决方案。主要用途是将 800Gb/s Quantum-2 交换机或 Spectrum-4 交换机连接到基于 OSFP/QSFP112 的 400Gb/s ConnectX-7 PCIe 网络适配器卡/BlueField-3 DPU。

-单端口 OSFP仅适用于 ConnectX-7/OSFP 网络适配器。

-BlueField-3/QSFP112 DPU 和 ConnectX-7/QSFP112 适配器需要 MCP7Y10 和 MCA7J65 铜缆上的 QSFP112 端。

-有源铜缆 (ACC) MCA7J60、MCA7J65的长度可提供 4 米和 5 米。

OSFP - 2x400G OSFP DAC/ACC连接示意图

OSFP - 2x400G QSFP112 DAC连接示意图

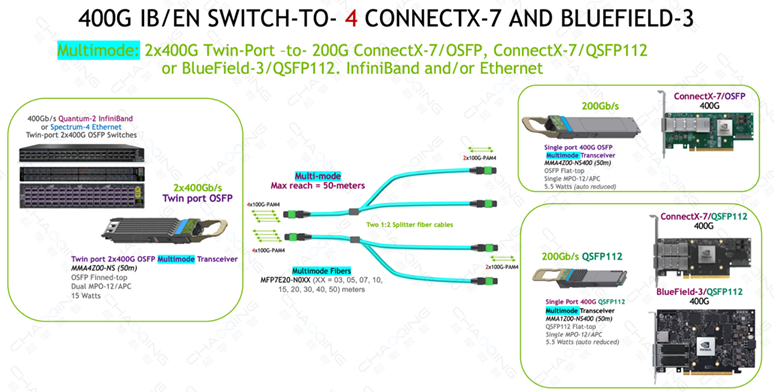

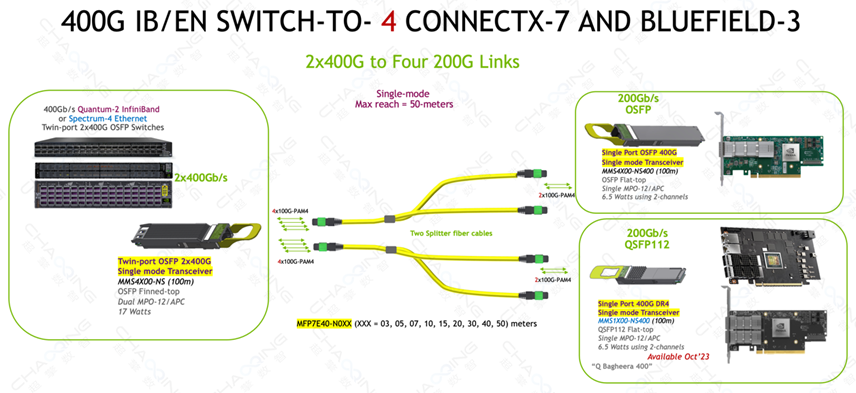

NDR InfiniBand Quantum-2交换机 —— 4 x 200G ConnectX-7(OSFP/QSFP112)Adapter/BlueField-3 DPU(QSFP112)

1、NDR Twin-port光模块

交换机侧:800G Twin-port OSFP光模块——MMA4Z00-NS(50m)、MMS4X00-NS(100m)

网卡侧:400G Single port OSFP/QSFP112光模块——MMA4Z00-NS400 / MMA1Z00-NS400(50m)、MMS4X00-NS400(100m)

使用两根 1:2 分支光纤跳线的双端口 OSFP 光模块最多可支持四个适配器和/或 DPU 组合。两根 4 通道 1:2 分支光纤跳线中的每根都可以连接到 OSFP 或 QSFP112 封装的 400G 光模块,最远传输距离可达 50 米。在 400G 光模块中仅激活其中的两个通道,从而实现 200G 应用。

-仅 ConnectX-7/OSFP 支持单端口 OSFP。

-QSFP112 封装光模块可用于 ConnectX-7/QSFP112 和BlueField-3/QSFP112 DPU。

-ConnectX-7 和 BlueField-3 网卡的任意组合可同时与双端口OSFP 光模块连接使用。

-单模直连光纤最大传输距离为 100 米,但 1:2 分支光纤跳线的最大传输距离为 50 米。

800G SR8 —— 4x200G SR2连接示意图

800G DR8 —— 4x200G DR2连接示意图

2、NDR Copper(DAC / ACC)

800Gb/s 双端口 OSFP至 4x200Gb/s OSFP/QSFP112 分支铜缆适用于 400Gb/s NVIDIA 端到端 Infiniband和以太网解决方案。主要用途是将 800Gb/s Quantum-2 交换机或 Spectrum-4 交换机连接到基于 OSFP/QSFP112 的 200Gb/s ConnectX-7 PCIe 网络适配器卡/BlueField-3 DPU。

-单端口 OSFP仅适用于 ConnectX-7/OSFP 网络适配器。

-BlueField-3/QSFP112 DPU 和 ConnectX-7/QSFP112 适配器需要 MCP7Y40 和 MCA7J75铜缆上的 QSFP112 端。

-有源铜缆 (ACC) MCA7J70、MCA7J75的长度可提供 4 米和 5 米。

OSFP - 4x200G OSFP DAC/ACC连接示意图

OSFP - 4x200G QSFP112 DAC连接示意图

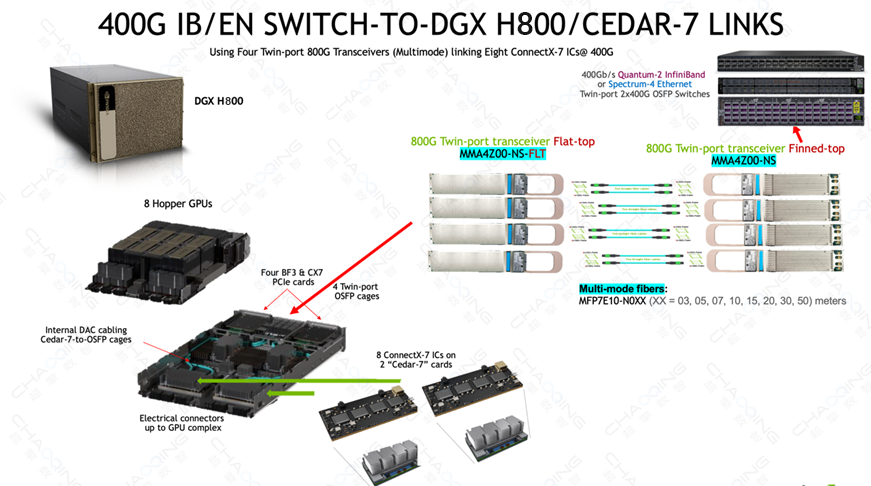

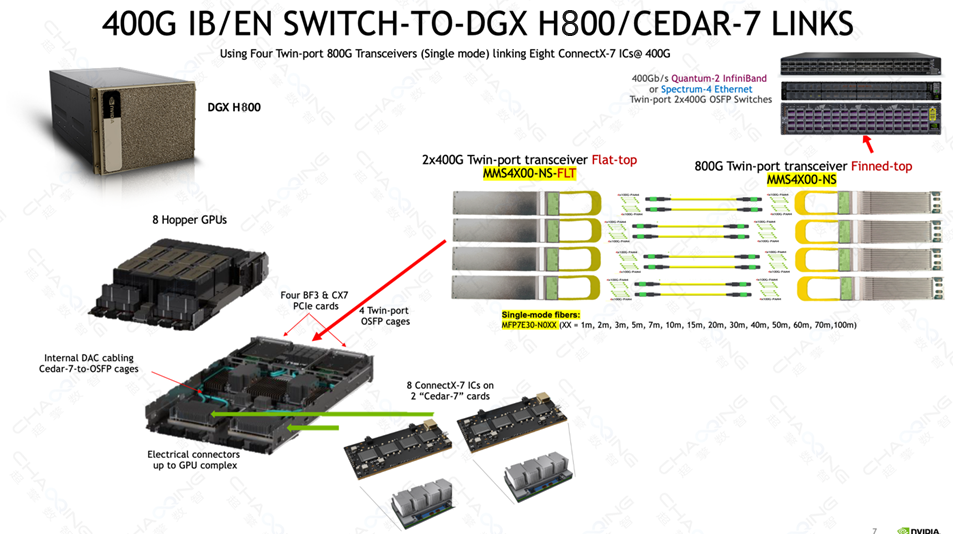

NDR InfiniBand Quantum-2交换机 —— DGX H800 GPU Systems

1、NDR光模块

DGX-H800 在顶部机箱部分包含 8 个“Hopper”H800 GPU,在底部服务器部分包含两个 CPU、存储以及 InfiniBand 和/或以太网网络设备。其中包含八个 400Gb/s ConnectX-7 IC,安装在两个称为“Cedar-7”板卡的夹层板上,用于 GPU 到 GPU InfiniBand 或以太网网络。板卡 I/O 在内部路由至四个 800G 双端口 OSFP 机箱,内置散热器安装于前面板上的机箱顶部。这需要在 DGX H800 中使用flat-top transceivers、ACC 和 DAC 线缆。由于交换机中的气流入口减少,400G IB/EN 交换机需要使用finned-top 2x400G 光模块进行额外冷却。

每个双端口 2x400G 光模块提供两条从 DGX 到 Quantum-2 或 Spectrum-4 交换机的 400G ConnectX-7 链路。与 DGX A800 相比,这减少了 ConnectX-7 板卡冗余、复杂性和光模块数量,DGX A800 使用 8 个独立的 HCA 和 8 个光模块或 AOC 线缆以及两个用于 InfiniBand 或以太网存储的附加 ConnectX-6。

此外,对于存储、集群和管理的传统网络,DGX-H800 还支持多达四个 ConnectX-7 和/或两个 BlueField-3 DPU 在 InfiniBand 和/或以太网中用于存储 I/O,以及支持使用 OSFP 或 QSFP112 光模块的 400G 或 200G 设备进行的额外网络。这些 PCIe 卡槽位于OSFP GPU机箱的两侧,并使用单独的电缆和/或光模块。

800G SR8连接示意图

800G DR8连接示意图

2、NDR Copper(DAC / ACC)

OSFP 平顶端Flat Top线缆可用于液冷交换机和 DGX H800 系统,其中,MCP4Y10-N0XX-FLT无源DAC电缆长度为0.5m和1m,MCA4J80有源ACC电缆连接到DGX-H800 Cedar 系统可使用的长度为3m。

800G DAC连接示意图

800G ACC连接示意图

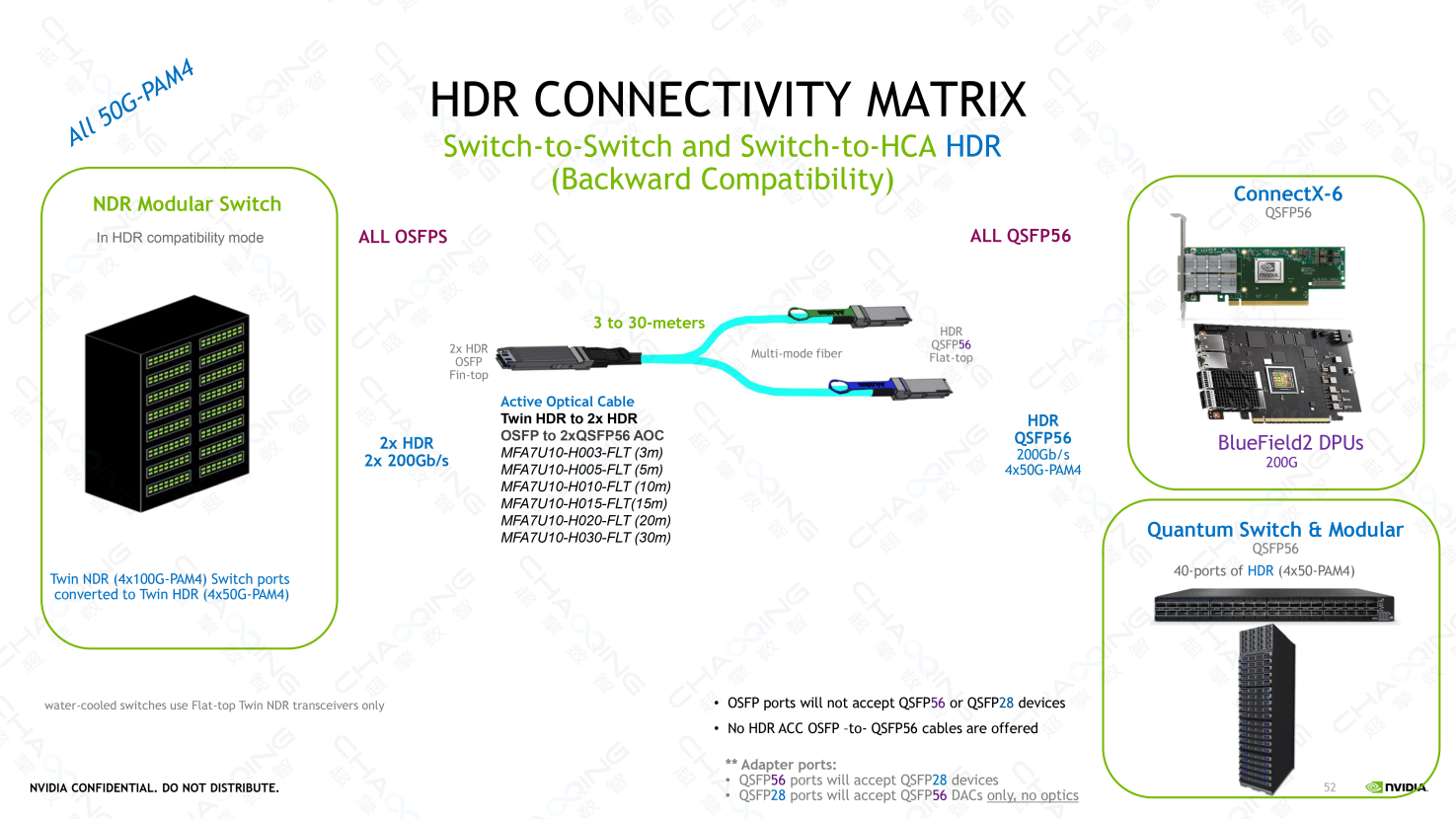

超擎数智NDR交换机到HDR设备连接方案

NDR InfiniBand Quantum-2交换机 —— 2 x HDR InfiniBand Quantum交换机

NDR InfiniBand Quantum-2交换机 —— 2 x 200G QSFP56 ConnectX-6 Adapter/BlueField-2 DPU

MFA7U10-H00X是一款 OSFP 至 2x QSFP56、400Gb/s 至 2 x 200Gb/s 有源分光器电缆 (AOC),将来自单个 OSFP 端上的 8 个 MMF(多模光纤)对中的每对数据信号连接到每个 QSFP56 多端口端的四对。MFA7U10-H00X用于将带有 OSFP 端口的 NDR 交换机连接到基于QSFP56 端口的2 个HDR 交换机或ConnectX-6适配器/BlueField-2 DPU 。

400G OSFP - 2x200G QSFP56 AOC线缆连接示意图